上一次跟大家介紹了Chip在的實驗室其中一個核心方向(繞射神經網路),接著跟大家介紹另一方向:虛擬染色(Virtual Staining)。這也是Chip在今年底左右想要參與的研究主題。在這個生醫AI相關的主題上,非常有名的GAN模型在其中扮演了關鍵腳色,取代了過去專家來進行染色標記、耗時又耗力的流程。

組織學染色

首先,甚麼是組織學染色呢?簡單來說就是辨別出病變的組織後藉由化學染劑進行染色,以方便後續診斷。組織學染色是臨床和生命科學研究中組織檢查的主要工具,已在病理學實驗室中常規進行,以協助評估病理生理學和疾病診斷。 儘管使用廣泛,但標準的組織學染色程序存在一些關鍵缺點:

1. 樣本準備的時間和金錢成本都相當高

2. 需要生物科學專家進行分辨

3. 在簡易設備很難進行

4. 染色用的化學物質會汙染環境

5. 染色時間太久會延遲到診斷

AI虛擬染色

虛擬染色是一種基於深度學習的數字生成組織學染色的方法,有可能徹底改變傳統的組織學染色工作流程。 通過消除對化學染色和有毒化合物的需求,虛擬染色為傳統染色方法提供了一種快速、經濟高效且準確的替代方法,這可能會提高診斷的準確性和速度,從而改善患者的治療效果並降低醫療保健成本。以下簡單列出其優勢。

1. 快速

2. 穩定可複製

3. 成本相對合理

4. 環境友善

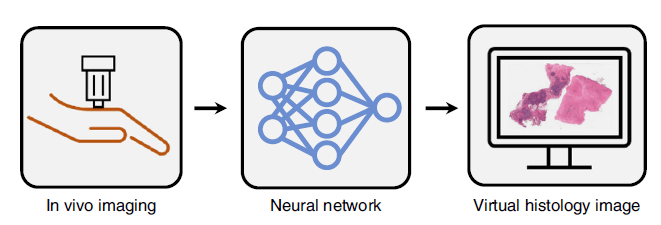

在收到生醫成像的影像後,我們即可以送往電腦由AI直接進行虛擬染色。如下圖所示:

AI染色轉換

在這邊Chip想跟大家介紹虛擬染色的相關技術:染色轉換。

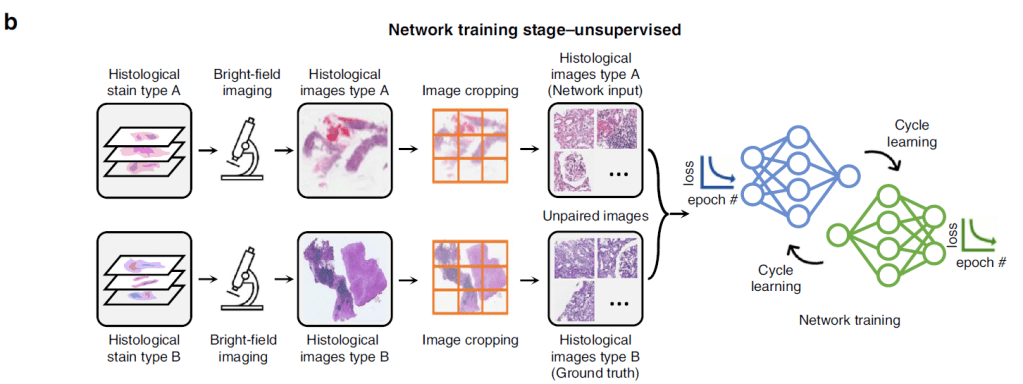

假設我們有來自實驗室A和實驗室B的染色結果(TypeA和TypeB染色),並希望以此來訓練我們的AI模型或者供診斷使用。這時候可能存在一個問題:因為兩所實驗室的染色劑差異或者是染色工法的不同,導致染色結果的色彩和特徵不一致,進而讓AI模型難以學習。此時我們可以利用訓練CycleGAN模型來進行風格轉換,TypeA到TypeB為Generator1,TypeB到TypeA為Generator2,並分別用Discrimminator1和Discrimminator2來進行分辨。這樣的訓練優勢是你不需要另一種type的標準答案即可進行訓練,也就是大家所說的無監督式訓練(unsupervised learning)。

在這之中我們運用Attention U-net作為產生圖像的generator,運用簡單的CNN作為分辨圖像的discrimminator。神經網路架構如下所示。(關於U-net這個十分泛用的神經網路和Attention model的概念,之後Chip打算另外寫文章來介紹。)

無監督學習降低了訓練資料的大量需求,可以在缺乏人力或專家標記的情況下更好的進行訓練。然而這樣的方法在量化轉換結果時有個困難:那就是沒有Ground Truth可以做比較。在這裡的研究中,其中一個方法就是在研究中使用色彩分布作為評量標準來評判轉換是否成功。在這裡我們基於樣本的色彩特性選擇使用YCbCr色彩空間來進行分析。YCbCr色彩空間是甚麼呢?簡單來說,這個空間利用Y、Cb、Cr三個向量表示一個像素的色彩,Y代表亮度分量,Cb和Cr分別代表藍色和紅色的色度分量。在YCbCr空間中每個像素由三個分量值組成,其中Y分量代表像素的亮度,而Cb和Cr分量則表示顏色信息。

首先我們把影像轉換成YCbCr的三通道資訊,接著分析虛擬染色結果的分別在Cb的histogram和Cr的histogram。y2相當於是色彩上的ground truth,與其重疊度愈高代表結果愈好。我們可以藉此分析比較不同模型(ex: CG2和G0)的表現差異:CG2相對於G0除了重疊率較高外,也沒有像G0出現Ground truth沒有的色彩面積。

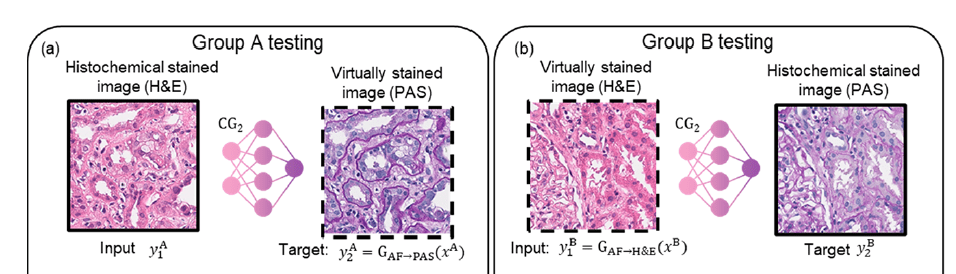

當使用者拿到TypeA染色的樣本,卻需要TypeB染色時,即可送入神經網路進行染色轉換,得到TypeB樣本去訓練AI模型或供診斷使用。反之我們也可以由TypeB染色樣本得到TypeA。實際的使用情境如下圖所示。

我們實驗室的最新一篇關於虛擬染色的評論文章發表在 Light: Science & Applications期刊上。 “我們相信這篇綜述論文將作為該研究領域技術發展的圖集,提供對虛擬染色最新進展的頂級理解,”引用一下我們教授的話,“我們希望它能激發讀者的靈感。不同的科學領域進一步擴大這一令人興奮的領域的範圍和應用,並繼續突破虛擬染色的可能性”。

如果對這個主題有興趣的朋友,歡迎留言或是email給我~

參考資料

1. Deep learning-enabled virtual histological staining of biological samples

2. Virtual Stain Transfer in Histology via Cascaded Deep Neural Networks

3. Virtual histological staining of unlabelled tissue-autofluorescence images via deep learning

發表留言